5 tecniche per come migliorare i tuoi prompt in ChatGPT-5

Se hai mai avuto la sensazione che le risposte di ChatGPT-5 non fossero all’altezza delle aspettative o che la qualità fosse diminuita rispetto alle versioni precedenti, non sei il solo. Molti utenti hanno notato un cambiamento, ma la buona notizia è che spesso il problema non risiede nel modello, ma nel modo in cui comunichiamo con esso. L’approccio alla scrittura dei prompt è cambiato in modo significativo e, per ottenere risultati eccellenti, è necessario adottare nuove strategie.

OpenAI stessa ha fornito una guida approfondita, originariamente pensata per gli sviluppatori che usano le API, ma che contiene preziosi suggerimenti applicabili anche da chi utilizza la versione web di ChatGPT. Analizzando questa documentazione, emergono cinque tecniche fondamentali che possono trasformare radicalmente la qualità delle risposte che riceviamo.

Questo articolo ti guiderà passo dopo passo attraverso queste cinque strategie ufficiali, semplificandole e traducendole in accorgimenti pratici. Imparerai a “istruire” l’intelligenza artificiale in modo più efficace, ottenendo output più strutturati, completi e ragionati. Non si tratta di “trucchetti”, ma di un vero e proprio metodo per dialogare con l’IA in modo più consapevole e potente.

La base di tutto: perché è cambiato il modo di scrivere i prompt

Con l’evoluzione dei modelli linguistici, è cambiata anche la loro capacità di “ragionare”. ChatGPT-5 è in grado di compiere processi di pensiero più complessi prima di generare una risposta. Se prima bastava una richiesta semplice e diretta, ora possiamo (e dobbiamo) guidarlo in questo processo di ragionamento per ottenere il massimo. Le tecniche che vedremo sfruttano proprio questa capacità, spingendo il modello a pianificare, validare e riflettere sul proprio lavoro, proprio come farebbe un essere umano.

Inoltre, con l’introduzione di funzionalità come la modalità “Thinking”, abbiamo un controllo ancora maggiore sul livello di elaborazione che l’IA dedica ai nostri task. Abilitare questa modalità per compiti complessi, come la stesura di una strategia di marketing, permette al modello di dedicare più tempo all’analisi e alla strutturazione del pensiero, portando a risultati nettamente superiori.

Pronto a scoprire come trasformare i tuoi prompt da semplici domande a istruzioni potenti ed efficaci? Iniziamo.

1. La regola della pianificazione (plan first rule)

La prima e forse più impattante tecnica consiste nel chiedere a ChatGPT di pianificare il suo lavoro prima di eseguirlo. È un concetto semplice ma incredibilmente efficace: invece di lanciarlo direttamente nella stesura di un testo complesso, gli chiediamo di creare prima una scaletta o una checklist.

Come funziona?

Questo approccio costringe il modello a fare un passo indietro e a pensare in modo strutturato. È un po’ come il meccanismo di “Deep Research” che alcuni strumenti IA utilizzano: prima di cercare le informazioni, definiscono un piano d’azione (es. “Per rispondere a questa domanda, farò lo step A, B e C”).

Aggiungendo una semplice riga al nostro prompt, possiamo replicare questo processo. Chiedendogli di iniziare fornendo una checklist dei passaggi necessari, lo obblighiamo a delineare la struttura della sua risposta. Una volta approvata o semplicemente generata questa scaletta, il modello la seguirà punto per punto, garantendo un output molto più coerente, completo e logico.

Esempio pratico

Immaginiamo di voler definire un piano di contenuti per un nuovo progetto.

Prompt semplice:

Crea un piano di contenuti trimestrale per promuovere un nuovo servizio di subscription box mensile per prodotti tipici italiani.

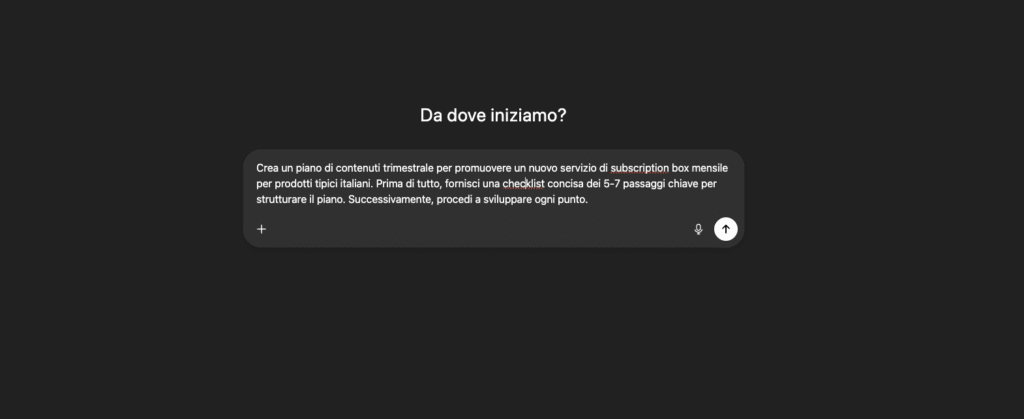

Prompt con la regola della pianificazione:

*Crea un piano di contenuti trimestrale per promuovere un nuovo servizio di subscription box mensile per prodotti tipici italiani. Prima di tutto, fornisci una checklist concisa dei 5-7 passaggi chiave per strutturare il piano. Successivamente, procedi a sviluppare ogni punto. *

La parte in grassetto è quella che fa tutta la differenza. ChatGPT prima creerà una scaletta, come:

- Definizione degli obiettivi e dei KPI del piano

- Identificazione del pubblico target e delle personas

- Selezione dei canali di comunicazione (blog, social, newsletter)

- Definizione dei pilastri di contenuto (es. storie dei produttori, ricette, cultura regionale)

- Creazione di un calendario editoriale di massima

- Strategia di promozione dei contenuti

E solo dopo svilupperà ogni singolo punto nel dettaglio. Il risultato finale sarà un documento infinitamente più organizzato e strategico.

2. La validazione post-azione (post action validation)

La seconda tecnica si basa sulla prima e aggiunge un ulteriore livello di controllo e qualità. Dopo aver chiesto all’IA di pianificare e redigere, le chiediamo di fare un’auto-revisione critica del proprio lavoro.

Come funziona?

È un passaggio quasi “meta”: chiediamo a ChatGPT di analizzare la risposta che lui stesso ha prodotto, di valutarne la coerenza con gli obiettivi e di suggerire eventuali correzioni o miglioramenti. Questo simula perfettamente il processo di revisione umano: quando scriviamo un documento importante, una bozza di un libro o una presentazione, la rileggiamo a distanza di tempo per individuare errori, frasi poco chiare o passaggi da migliorare.

Aggiungendo un’istruzione specifica, possiamo far fare la stessa cosa all’IA, ottenendo una versione finale del testo più rifinita e accurata.

Esempio pratico

Evolviamo il prompt precedente.

Prompt con pianificazione e validazione:

*Crea un piano di contenuti trimestrale per promuovere un nuovo servizio di subscription box mensile per prodotti tipici italiani. Prima di tutto, fornisci una checklist concisa […]. Successivamente, procedi a sviluppare ogni punto. Infine, dopo aver presentato il piano, analizza criticamente ogni fase, indicando se è allineata con l’obiettivo di aumentare gli iscritti e suggerendo possibili ottimizzazioni. *

Con questa aggiunta, l’output di ChatGPT non si fermerà al piano di contenuti, ma includerà una nuova sezione finale, simile a questa:

Validazione critica del piano:

- Fase 1 (Obiettivi e KPI): Esito OK. Gli obiettivi sono chiari e misurabili.

- Fase 2 (Target): Esito POSITIVO. Le personas sono ben definite, ma si potrebbe aggiungere un focus sugli italiani all’estero come segmento secondario.

- Fase 3 (Canali): Esito DA MIGLIORARE. Si suggerisce di integrare anche collaborazioni con food blogger e influencer per aumentare la visibilità iniziale, un aspetto non menzionato nel piano.

Questo processo di auto-correzione non solo migliora la qualità della risposta, ma ci fornisce anche spunti di riflessione aggiuntivi che potremmo non aver considerato.

3. I criteri di interruzione anticipata (early stop criteria)

Questa terza tecnica trasforma ChatGPT da un semplice esecutore a un collaboratore proattivo. Invece di lasciarlo procedere anche quando le informazioni sono incomplete, gli diamo il permesso (e l’ordine) di fermarsi e chiederci chiarimenti.

Come funziona?

Spesso, quando diamo un prompt, omettiamo involontariamente dettagli cruciali. Un’IA “obbediente” cercherà di riempire questi vuoti con delle ipotesi, che potrebbero però essere sbagliate e portare a un risultato impreciso o non pertinente. Con i “criteri di interruzione anticipata”, gli diciamo: “Se ti accorgi che manca un’informazione fondamentale per darmi una risposta accurata, fermati e fammi una domanda”.

Questo approccio è fondamentale per evitare i bias di conferma (cioè usare l’IA solo per confermare le nostre idee) e per sfruttarla invece come un vero e proprio consulente critico, un “avvocato del diavolo” che ci aiuta a identificare le lacune nel nostro ragionamento.

Esempio pratico

Aggiungiamo un altro pezzo al nostro prompt sempre più sofisticato.

Prompt completo con criterio di interruzione:

*Crea un piano di contenuti trimestrale per un servizio di subscription box. Prima fornisci una checklist, poi sviluppa il piano e infine analizzalo criticamente. Tuttavia, interrompi il processo e fammi delle domande se ti mancano dati essenziali per creare una strategia realistica ed efficace. *

In questo caso, il modello potrebbe fermarsi subito e chiedere:

“Per procedere, ho bisogno di alcuni chiarimenti: Qual è il budget approssimativo per la promozione dei contenuti? Esiste già un sito web o un blog? Quali sono i principali concorrenti che hai identificato?”

Questo dialogo trasforma un monologo in una conversazione collaborativa, aumentando esponenzialmente la pertinenza e l’efficacia della risposta finale.

4. Specificare lo sforzo di ragionamento (reasoning effort)

Non tutte le richieste richiedono lo stesso livello di profondità. A volte abbiamo bisogno di una risposta rapida e sintetica, altre volte di un’analisi complessa e dettagliata. La quarta tecnica ci permette di specificare esplicitamente “quanto” vogliamo che ChatGPT pensi prima di rispondere.

Come funziona?

Questa istruzione è un vero e proprio parametro che possiamo inserire nel prompt per regolare la profondità di elaborazione. È diverso dal semplice attivare o disattivare la modalità “Thinking”; qui stiamo dando un’indicazione quantitativa sullo sforzo computazionale da dedicare.

Secondo la guida di OpenAI, esistono diversi livelli, tipicamente:

lowmediumhigh

Indicando uno di questi livelli, possiamo influenzare il tempo che il modello dedica al ragionamento preliminare. Più alto è lo sforzo, più tempo impiegherà a “pensare” prima di iniziare a scrivere, il che si traduce generalmente in risposte più approfondite e sfaccettate.

Esempio pratico

Aggiungiamo questo parametro al nostro prompt.

Prompt con sforzo di ragionamento:

Crea un piano di contenuti trimestrale […]. Per questo compito, utilizza un alto livello di approfondimento analitico (reasoning_effort = high). Inizia fornendo una checklist […]

Eseguendo lo stesso prompt prima con reasoning_effort = low e poi con high, noteremmo una differenza significativa nel tempo di “thinking” mostrato dall’interfaccia (es. 9 secondi contro 21 secondi). Sebbene i numeri esatti possano variare, il concetto è chiaro: abbiamo il controllo sul livello di approfondimento. Per un brainstorming veloce useremo low, per un’analisi strategica high.

5. Controllare il livello di verbosità (verbosity level)

L’ultima tecnica è simile alla precedente, ma si concentra sulla lunghezza e sul dettaglio della risposta finale, non sul processo di ragionamento che la precede. Ci permette di dire a ChatGPT se vogliamo una risposta breve e diretta o una lunga e dettagliata.

Come funziona?

Anche in questo caso, si tratta di un parametro da inserire nel prompt per definire il livello di “loquacità” del modello. I livelli sono simili a quelli visti prima:

lowmediumhigh

Qualcuno potrebbe obiettare: “Ma non basta scrivere ‘sii breve e conciso’ o ‘fornisci una risposta dettagliata’?”. Certo, il linguaggio naturale funziona, ma l’uso di questi parametri è più rapido, standardizzato e spesso più affidabile. È un modo più “tecnico” e diretto per comunicare le nostre preferenze sulla formattazione dell’output.

Esempio pratico

Vediamo un esempio semplice e chiaro.

Prompt con bassa verbosità:

*Suggerisci cinque destinazioni in Italia per un weekend all’insegna del relax. (verbosity = low) *

Risultato: Una lista puntata e basta.

- Saturnia, Toscana

- Orta San Giulio, Piemonte

- Val d’Orcia, Toscana

- Le colline del Prosecco, Veneto

- La costiera dei Trabocchi, Abruzzo

Prompt con alta verbosità:

*Suggerisci cinque destinazioni in Italia per un weekend all’insegna del relax. (verbosity = high) *

Risultato: Una risposta molto più elaborata, con un’introduzione, e per ogni destinazione una breve descrizione del luogo, il tipo di attività rilassanti che si possono fare (es. terme, passeggiate, enogastronomia) e il periodo migliore per visitarla.

Questa tecnica è estremamente utile per adattare lo stile della risposta al contesto: low per ottenere dati rapidi, high per generare bozze di articoli o documenti completi.

Il promptimizer di Open AI

Open AI ha messo a disposizione un tool gratuito chiamato Promptimizer. Questo strumento è progettato per automatizzare l’ottimizzazione dei prompt.

Il funzionamento è semplice: l’utente inserisce un prompt di base, che possiamo definire “incompleto,” “semplice” o “non strutturato” (come la semplice richiesta di una strategia di mercato). Il Promptimizer prende questo input e, in automatico, lo elabora applicando le linee guida della guida ufficiale di Open AI, strutturando e ottimizzando il prompt.

Sebbene il risultato ottimizzato non sia necessariamente identico a quello prodotto manualmente applicando le cinque regole in ordine, il tool apporta modifiche avanzate e strutturate. È anche possibile visualizzare ogni singola modifica apportata al prompt originale, che sono esattamente quelle prese dalla guida ufficiale. Questo tool è accessibile gratuitamente ed è un modo rapido per migliorare la qualità delle richieste.

Perché imparare a “pescare”

L’esistenza di un tool automatico e di una guida dettagliata solleva una domanda cruciale: perché imparare queste cinque tecniche manualmente?.

La risposta risiede nell’importanza di comprendere il meccanismo sottostante. Utilizzare il Promptimizer per ottimizzare le richieste è sicuramente comodo e veloce, e molti lo fanno regolarmente. Tuttavia, la vera consapevolezza arriva solo quando si capisce cosa c’è dentro quell’ottimizzazione.

È fondamentale comprendere il perché Open AI consiglia proprio queste cinque tecniche:

- Perché è importante la checklist? Per forzare il modello a crearsi un piano prima di agire.

- Perché è importante la post validation? Per fargli ricontrollare e rivedere le risposte.

Questo concetto è ben espresso in una metafora popolare: è meglio regalare il pesce a una persona per sfamarla per un giorno, oppure insegnarle a pescare per sfamarla per tutta la vita?.

L’obiettivo di apprendere queste tecniche a fondo è rendere l’utente autonomo. Se si comprende come e perché funzionano la Plan rule, la Post validation, l’Early stop criteria, il Reasoning effort e il Verbosity level, allora ogni volta che si scriverà un prompt, si avrà una consapevolezza diversa, un’attenzione maggiore e una capacità di personalizzazione che va oltre l’automazione del tool.

La padronanza di queste cinque tecniche, pur partendo da una guida tecnica, rappresenta il passo essenziale per sbloccare il massimo potenziale di GPT-5 nell’uso quotidiano, assicurando che le risposte siano sempre della massima qualità possibile.

Domande frequenti (FAQ) sull’ottimizzazione dei prompt GPT-5

Perché dovrei scrivere “verbosity = low” se posso dire “rispondi in breve”?

GPT-5 capisce benissimo se gli dici di rispondere in modo breve. Tuttavia, usare la scritta “verbosity = low” (che significa “poco dettaglio”) è *molto più veloce* e automatico. Non devi scrivere una frase intera. Inserendo solo il codice, il programma capisce subito quanto lunga deve essere la risposta (corta, media o lunga). Questo è utile se vuoi risposte sempre brevi o sempre lunghe, senza dovercelo specificare ogni volta.

A cosa serve dire a GPT-5 di “fermarsi” se non è sicuro di una risposta?

Questa tecnica, chiamata *Early stop criteria*, serve a rendere il modello più critico. Noi gli chiediamo di *fermare il lavoro e fare domande* se capisce che gli manca un’informazione importante per rispondere bene. Invece di inventare o andare avanti con una risposta incompleta, gli diciamo: “Se ti accorgi che manca qualcosa, dimmelo”. Questo è come fargli fare “l’avvocato del diavolo” per assicurarsi che la proposta finale sia giusta e completa.

Cosa cambia se scelgo quanto deve “pensare” GPT-5?

Il parametro *Reasoning effort* (sforzo di ragionamento) ti permette di decidere *quanto tempo* e con quale *attenzione* il modello deve riflettere prima di darti la risposta. Puoi scegliere tra livelli come *low*, *medium* o *high* (basso, medio, alto). La differenza si vede nel tempo che ci mette a ragionare. Ad esempio, in un compito difficile, con il livello *low* può pensare solo per pochi secondi (ad esempio, 9 secondi), mentre con il livello *high* il tempo di pensiero può aumentare molto (ad esempio, 21 secondi o anche 40 secondi). Questo ti dà controllo sulla qualità e sulla profondità del ragionamento.

Perché devo chiedere a GPT-5 di fare una lista (checklist) prima di rispondere?

Questa tecnica, chiamata *Plan first rule*, è il primo suggerimento importante di Open AI. Chiedere di fare una *lista concisa* dei passaggi (chiamata checklist) prima di iniziare la risposta, obbliga il modello a *pianificare* il lavoro. È come se si creasse un indice da seguire. Di conseguenza, la risposta finale sarà sempre *più ordinata, completa e ben pensata*, perché segue il piano che si è creato prima.

È meglio imparare a fare queste cose a mano o usare lo strumento automatico di ottimizzazione?

Open AI ha creato uno strumento gratuito, il *Promptimizer*, che migliora automaticamente le tue richieste. Questo strumento è molto comodo e veloce. Tuttavia, è fondamentale *capire il perché* queste tecniche funzionano. Capire a fondo perché la checklist è importante (serve per forzare un piano) e perché la *Post validation* è utile (per fargli controllare la sua risposta) ti rende *autonomo*. Usare il tool è come ricevere il pesce, ma imparare le tecniche è come imparare a pescare per tutta la vita.

OpenClaw: la verità analizziamolo insieme

OpenClaw: la verità analizziamolo insieme Il mondo dell’intelligenza artificiale corre a una velocità che, anche per chi come me mastica…

Elementor Editor V4: La Rivoluzione “CSS-First”

Elementor Editor V4: La Rivoluzione “CSS-First” del Web Design Se lavori nel mondo dello sviluppo web con WordPress, c’è una data…

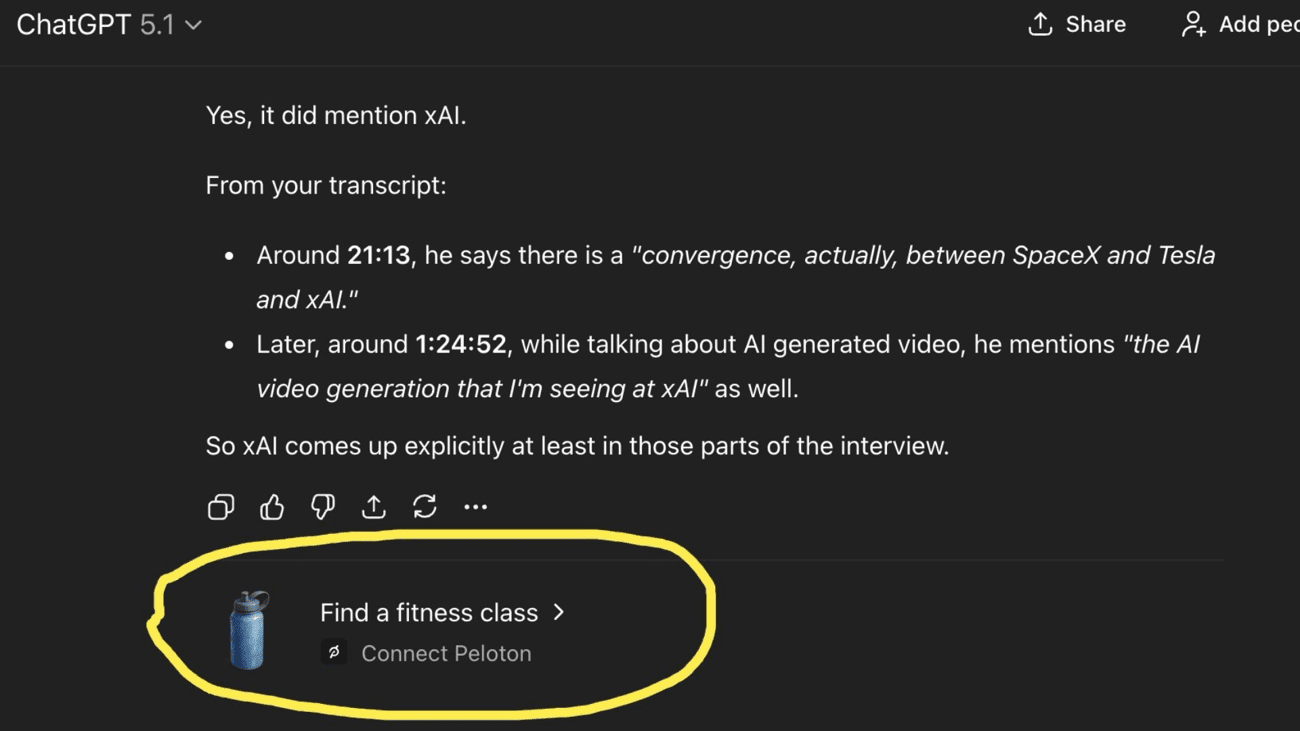

Annunci pubblicitari in ChatGPT ecco cosa sta succedendo

Annunci pubblicitari in ChatGPT ecco cosa sta succedendo Per molto tempo, ChatGPT è stato come un amico che ti offre un…

Reddit vola (+81%): il social che ha battuto tutti

Reddit vola (+81%): il social che ha battuto tutti Se passi ore a scrollare tra post e video, potresti non crederci,…

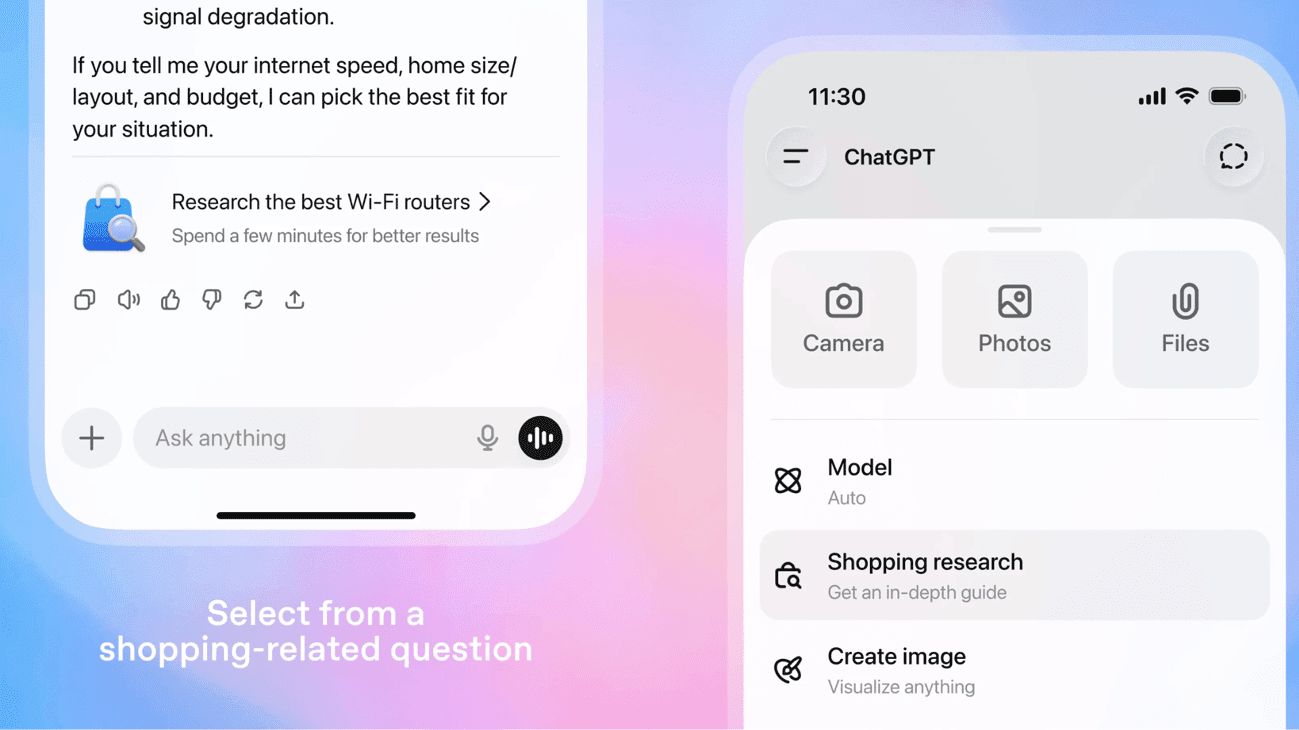

ChatGPT diventa il tuo assistente per gli acquisti

ChatGPT diventa il tuo assistente per gli acquisti Siamo onesti: quante volte vi siete trovati a navigare tra decine di schede,…

Gemini 3 novità: vediamolo in azione

Gemini 3 novità: vediamolo in azione Dopo un periodo in cui sembrava che tutti i modelli di IA stessero più o…