Descubre las novedades del nuevo modelo AI de OpenAI: GPT-4o

OpenAI ha lanzado recientemente su nuevo modelo de inteligencia artificial, GPT-4o, una innovación que promete transformar radicalmente la forma en que interactuamos con las computadoras. Este artículo explorará las nuevas capacidades de GPT-4o, sus aplicaciones prácticas y las mejoras respecto a los modelos anteriores.

Una nueva era en la interacción humano-computadora

¿Qué es GPT-4o?

GPT-4o, donde “o” significa “omni”, representa un avance significativo en la tecnología de IA. Este modelo está diseñado para aceptar entradas en cualquier combinación de texto, audio, imágenes y video, generando respuestas que pueden ser textos, audio o imágenes. Esta capacidad multimodal hace de GPT-4o una herramienta increíblemente versátil y poderosa.

Respuesta en tiempo real

Una de las características más sorprendentes de GPT-4o es su velocidad de respuesta. El modelo es capaz de responder a entradas de audio en solo 232 milisegundos, con un promedio de 320 milisegundos, comparable a los tiempos de respuesta humanos. Esto hace que las conversaciones con la IA sean mucho más naturales y fluidas en comparación con los modelos anteriores.

Una única red neuronal para todas las modalidades

A diferencia de los modelos anteriores, que utilizaban procesos separados para transcribir audio a texto, procesar el texto y luego convertir el texto en audio, GPT-4o utiliza una única red neuronal para manejar todas estas tareas. Este enfoque integrado permite al modelo mantener una comprensión más rica del contexto, el tono y los matices emocionales, mejorando significativamente la experiencia del usuario.

Ejemplos de aplicaciones prácticas

Interacción entre dos GPT-4o

GPT-4o puede simular interacciones complejas entre dos entidades de IA, como conversaciones, juegos de mesa como “Piedra, Papel, Tijera” e incluso armonizar juntos en canciones. Esto abre nuevas posibilidades para aplicaciones creativas y de entretenimiento.

Preparación para entrevistas

GPT-4o es capaz de asistir en la preparación de entrevistas, ofreciendo respuestas simuladas y retroalimentación sobre posibles preguntas. Esta funcionalidad es particularmente útil para quienes se preparan para entrevistas de trabajo o entrevistas importantes.

Traducción en tiempo real

El modelo es capaz de traducir discursos en tiempo real, una función que puede ser utilizada en contextos internacionales para facilitar la comunicación entre personas de diferentes idiomas.

Comprensión visual y narrativa

GPT-4o también destaca en la comprensión de imágenes y la narración visual. Por ejemplo, puede describir detalladamente lo que ve en una foto o un video, haciendo posibles nuevas formas de asistencia visual para personas ciegas o con baja visión.

Mira algunos ejemplos en video directamente desde el canal de YouTube de OpenAI

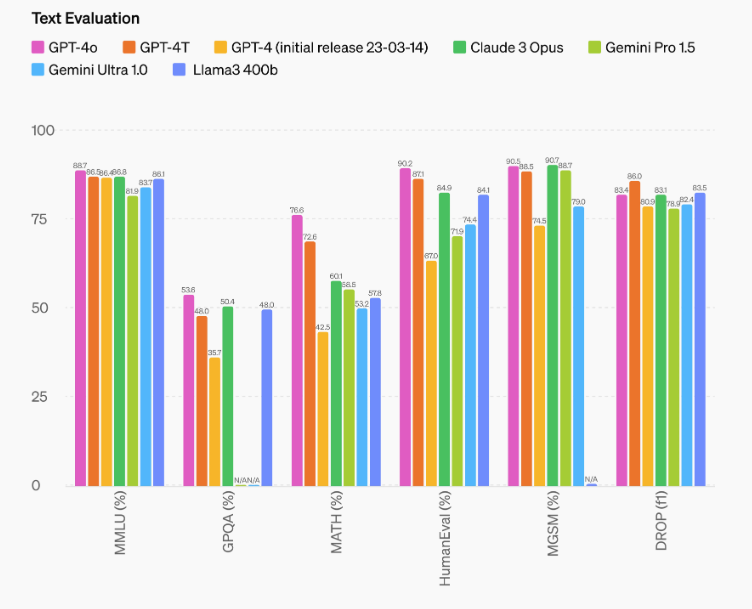

Rendimiento y evaluaciones

Evaluaciones tradicionales

En términos de evaluaciones tradicionales, GPT-4o alcanza niveles de rendimiento comparables a GPT-4 Turbo en lo que respecta a texto, razonamiento y codificación. Sin embargo, establece nuevos estándares para las capacidades multilingües, de audio y visuales.

Reconocimiento vocal

GPT-4o mejora notablemente las prestaciones de reconocimiento vocal en comparación con Whisper-v3, especialmente para los idiomas menos difundidos. Esto lo convierte en una herramienta más inclusiva y accesible para una amplia gama de usuarios globales.

Traducción de audio

El modelo establece un nuevo estado del arte en la traducción del habla, superando a Whisper-v3 en los benchmarks MLS. Esta mejora es crucial para las aplicaciones que requieren traducciones precisas y rápidas.

Comprensión visual

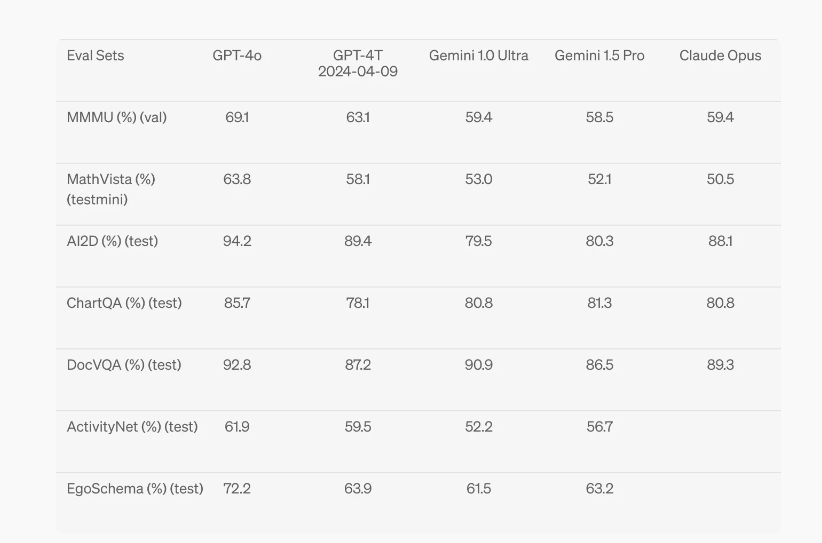

GPT-4o destaca en la percepción visual, obteniendo resultados de alto nivel en benchmarks como MMMU, MathVista y ChartQA. Estos resultados se obtienen con evaluaciones zero-shot, demostrando la capacidad del modelo para comprender y analizar imágenes sin necesidad de entrenamiento específico en esas tareas.

Veamos una galería de imágenes sobre el rendimiento de GPT-4o tomadas del sitio web de OpenAI

Compresión lingüística

Una de las innovaciones técnicas de GPT-4o es el nuevo tokenizador, que comprime eficientemente los datos lingüísticos, reduciendo el número de tokens necesarios para representar frases en diferentes idiomas. Esto no solo mejora la eficiencia del modelo, sino que también amplía su accesibilidad y efectividad en contextos multilingües.

Ejemplos de compresión de tokens

- Gujarati: 4,4 veces menos tokens.

- Telugu: 3,5 veces menos tokens.

- Tamil: 3,3 veces menos tokens.

- Marathi: 2,9 veces menos tokens.

- Hindi: 2,9 veces menos tokens.

- Urdu: 2,5 veces menos tokens.

Estas mejoras hacen que GPT-4o sea particularmente poderoso para los idiomas que tradicionalmente tienen una representación menos eficiente en los modelos de lenguaje.

Seguridad y limitaciones

Seguridad integrada

La seguridad de GPT-4o ha sido una prioridad desde el diseño. El modelo utiliza técnicas avanzadas para filtrar los datos de entrenamiento y refinar el comportamiento post-entrenamiento, asegurando que las interacciones sean seguras y apropiadas.

Evaluaciones externas

El modelo ha sido sometido a una amplia evaluación por parte de expertos externos en sectores como la psicología social, la parcialidad y la equidad, y la desinformación. Estos expertos han contribuido a identificar y mitigar los riesgos potenciales introducidos por las nuevas modalidades.

Limitaciones actuales

A pesar de los avances, GPT-4o aún presenta algunas limitaciones. Por ejemplo, las modalidades de audio presentan riesgos únicos que requieren más perfeccionamiento. Por el momento, las salidas de audio estarán limitadas a una selección de voces preestablecidas, respetando las políticas de seguridad existentes.

Disponibilidad del modelo

Lanzamiento y acceso

GPT-4o representa un avance significativo en la usabilidad práctica de la inteligencia artificial. A partir de hoy, las capacidades de texto e imagen de GPT-4o están disponibles en ChatGPT, con un acceso ampliado para los usuarios del nivel gratuito y hasta 5 veces el límite de mensajes para los usuarios Plus.

Aquí tienes un ejemplo de cuando agotamos los mensajes en la versión gratuita de GPT-4o

Acceso API

Los desarrolladores pueden ahora acceder a GPT-4o a través de la API como modelo de texto y visión. Este modelo es dos veces más rápido, cuesta la mitad y ofrece límites de velocidad cinco veces superiores en comparación con GPT-4 Turbo. El soporte para las nuevas capacidades de audio y video de GPT-4o estará pronto disponible para un grupo seleccionado de socios de confianza.

Tabla de Resumen

| Punto Importante | Detalles |

|---|---|

| Nombre del Modelo | GPT-4o (Omni) |

| Tiempo de Respuesta de Audio | Respuesta en tan solo 232 ms, con un promedio de 320 ms, similar al tiempo de respuesta humano en una conversación |

| Capacidades Multimodales | Acepta entradas de texto, audio, imagen y video; genera salidas de texto, audio e imagen. Todo procesado por la misma red neuronal, permitiendo una comprensión más rica y respuestas más naturales |

| Interacción y Música | Puede interactuar con otros modelos GPT-4o, cantar y armonizar, jugar a piedra, papel o tijera, y participar en situaciones humorísticas como contar chistes o ser sarcástico |

| Narrativas Visuales | Capaz de generar y manipular imágenes detalladas, como mostrar un robot escribiendo en una máquina de escribir, y modificar escenas de manera interactiva, como rasgar una hoja de papel |

| Diseño de Personajes | Crea personajes visuales dinámicos y amigables, como Geary el robot, que puede posar y realizar actividades como jugar frisbee |

| Evaluación de Texto | Alta puntuación en evaluaciones de razonamiento textual: MMLU 0-shot CoT: 88.7%, MMLU 5-shot no-CoT: 87.2%. Utiliza la nueva biblioteca de evaluaciones simples de OpenAI |

| Reconocimiento de Voz | Mejora significativa en el rendimiento de reconocimiento de voz sobre Whisper-v3, especialmente en idiomas con menos recursos, proporcionando transcripciones más precisas y eficientes |

| Comprensión Multilingüe | Supera a GPT-4 en el benchmark M3Exam, que evalúa la comprensión en múltiples idiomas y en visiones complejas, mostrando mejores resultados en todas las lenguas probadas |

| Seguridad del Modelo | Incorpora medidas de seguridad avanzadas como filtrado de datos y refinamiento del comportamiento mediante post-entrenamiento. Evaluado por más de 70 expertos externos en psicología social, equidad y desinformación. Implementa guardarraíles para salidas de voz |

| Disponibilidad | Comienza a estar disponible en ChatGPT para usuarios gratuitos y Plus, con capacidades extendidas en la API para desarrolladores. Audio y video en fase alfa para socios seleccionados. El nuevo modo de voz se lanzará pronto para usuarios de ChatGPT Plus |

| Rendimiento Comparativo | Es 2 veces más rápido, la mitad de caro y permite 5 veces más límites de velocidad en comparación con GPT-4 Turbo, haciendo que la IA sea más accesible y eficiente para una amplia gama de aplicaciones |

Conclusión

GPT-4o de OpenAI representa una revolución en la interacción humano-computadora, combinando capacidades avanzadas de texto, audio, imágenes y video en un único modelo. Con respuestas en tiempo real y una comprensión profunda de los contextos multimodales, GPT-4o promete transformar la experiencia del usuario en numerosos campos. Manténganse atentos para más actualizaciones y aplicaciones de este extraordinario modelo de inteligencia artificial.

Por Qué el Posicionamiento es la Clave del Éxito

Por Qué el Posicionamiento es la Clave del Éxito El mundo del marketing y el desarrollo empresarial está saturado de conceptos,…

Google Trends: Estrategias de Marketing

Google Trends: Estrategias de Marketing y Ventas para tu Negocio Google Trends es una herramienta poderosa que te permite aprovechar los…

Google Analytics 4 informe en tiempo real: todo lo que

Google Analytics 4 informe en tiempo real: todo lo que necesitas saber Google Analytics 4 (GA4) ha cambiado la forma en…

GeanAI y el creator marketing: el futuro de la publicidad

GeanAI y el creator marketing: el futuro de la publicidad en vídeo En la Advertising Week 2024, Meta presentó grandes actualizaciones…

Cómo Establecer el Presupuesto Adecuado para tus Campañas Publicitarias Online

¿Cuánto cuesta hacer campañas online? Guía completa sobre cómo establecer el presupuesto Si te preguntas cuánto cuesta hacer campañas online, no…

Nuevas Posibilidades para los Shorts de YouTube

Nuevas Posibilidades para los Shorts de YouTube YouTube sigue evolucionando y adaptándose a las tendencias del consumo de contenido, y los…

Las respuestas de Google a las preguntas de la comunidad:

Veamos cómo Google ha respondido a las mejores preguntas realizadas por la comunidad de entusiastas en la publicación de junio…

Descubre la Nueva IA de Apple: Apple Intelligence

Descubre la Nueva IA de Apple: Apple Intelligence Estoy feliz de presentaros la nueva IA de Apple: Apple Intelligence. Esta innovadora…