Revelado el Algoritmo de Google: Todos los Secretos al Descubierto

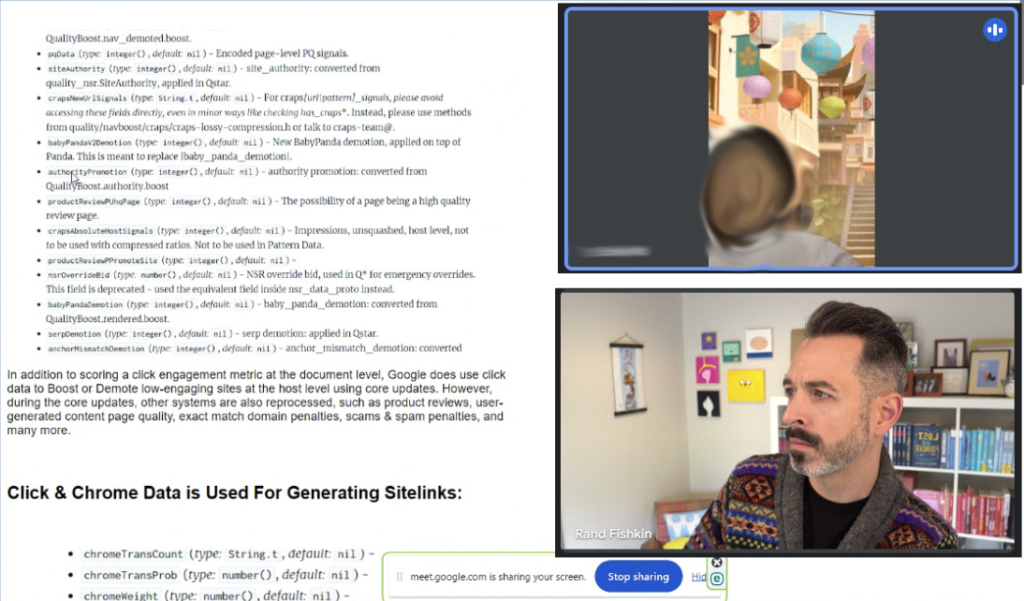

Recientemente, una filtración de documentos confidenciales de la API de búsqueda de Google ha sacudido el mundo del SEO (Optimización para Motores de Búsqueda). Rand Fishkin, conocido experto del sector, recibió miles de documentos de una fuente anónima que luego se reveló como Erfan Azimi. Estos documentos, publicados en GitHub entre marzo y mayo de 2024, ofrecen una visión inédita de las actividades internas de Google. Con la ayuda de ex empleados de Google y del experto en SEO Mike King, la autenticidad de los documentos ha sido confirmada. Veamos juntos lo que ha emergido de esta filtración de información.

Autenticación y Análisis de la Filtración

Verificación de la Autenticidad

Para verificar la autenticidad de los documentos, Rand Fishkin consultó a ex empleados de Google que reconocieron el formato, el estilo de anotación y los estándares internos de documentación utilizados por Google. También Mike King, un experto en SEO técnico, confirmó que los documentos parecen provenir directamente de la división de Búsqueda de Google. Esta doble verificación ha reforzado la credibilidad de los documentos filtrados.

Naturaleza de los Documentos

Los documentos de la API de búsqueda de Google sirven como un catálogo para los miembros del equipo del motor de búsqueda, delineando los elementos de datos disponibles y las formas de acceder a ellos. A diferencia de un catálogo público, el funcionamiento interno de la búsqueda de Google es altamente confidencial, lo que hace que esta filtración de información sea extremadamente significativa por su alcance y nivel de detalle.

Puntos Clave de la Filtración de Información

Navboost y el Comportamiento de los Clics

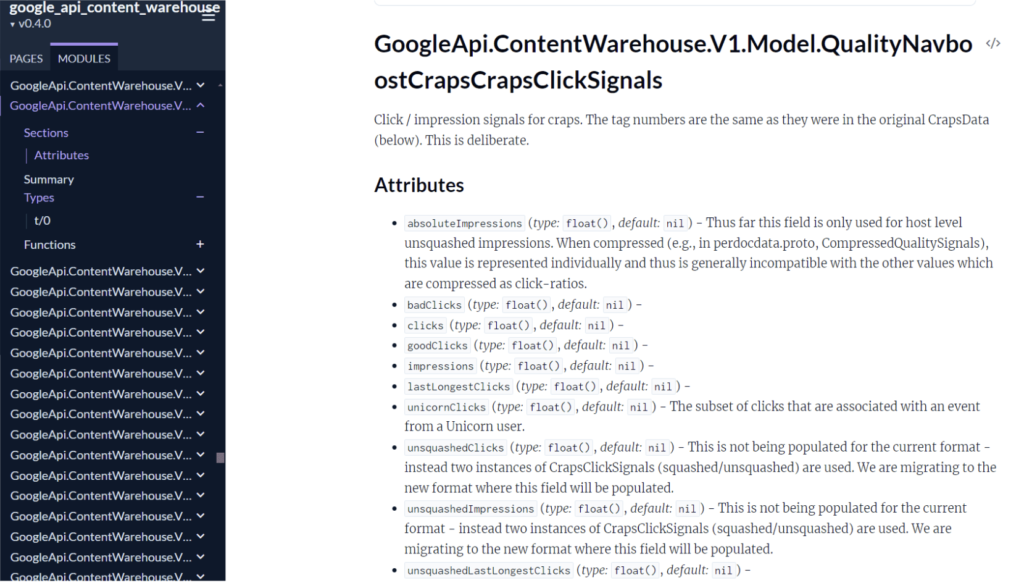

Uno de los aspectos más relevantes que emergieron de los documentos es el uso de funcionalidades como «goodClicks», «badClicks» y «lastLongestClicks». Estos términos indican que Google rastrea y utiliza el comportamiento de los clics de los usuarios para determinar los rankings de búsqueda. Esto confirma las declaraciones del vicepresidente de búsqueda de Google, Pandu Nayak, quien en el caso DOJ habló del papel de «navboost» en los resultados de búsqueda. En esencia, Google evalúa los clics para comprender mejor las preferencias de los usuarios y mejorar la relevancia de los resultados de búsqueda.

Uso de los Clickstream del Navegador Chrome

La filtración de información revela que Google utiliza los datos de clics de los navegadores Chrome para determinar las páginas más populares de un sitio web. Esto tiene un impacto significativo en funcionalidades como los sitelinks, que son los enlaces adicionales mostrados bajo algunos resultados de búsqueda. Los datos recogidos de los clickstream ayudan a Google a identificar las páginas más relevantes y útiles para los usuarios, influyendo así en el posicionamiento en los resultados de búsqueda.

Listas Blancas en Sectores Específicos

Los documentos filtrados indican que Google utiliza listas blancas para determinados sectores y temas, como viajes, Covid-19 y política. Esto sugiere que Google interviene manualmente en los resultados de búsqueda para temas potencialmente controvertidos o problemáticos. Las listas blancas ayudan a Google a garantizar que la información mostrada sea precisa y confiable, especialmente en sectores sensibles.

Feedback de los Evaluadores de Calidad

Otro aspecto interesante es el uso del feedback de la plataforma de evaluación de calidad de Google, EWOK. Los documentos revelan que el feedback de los evaluadores de calidad se utiliza directamente en los sistemas de búsqueda de Google. Esto significa que las evaluaciones humanas juegan un papel importante en los rankings de búsqueda, influyendo en qué páginas se consideran de alta calidad y merecedoras de un buen posicionamiento.

Ponderación de los Enlaces Basada en los Datos de los Clics

La filtración de información sugiere que Google utiliza los datos de clics para determinar cómo ponderar los enlaces en las clasificaciones. Los documentos indican que Google clasifica los índices de enlaces en función de la calidad, utilizando los datos de clics para determinar en qué nivel se encuentra un documento. Los enlaces de índices de alta calidad tienen más probabilidades de transmitir señales de ranking, mientras que los de baja calidad son ignorados. Este sistema ayuda a Google a mejorar la relevancia y la fiabilidad de los resultados de búsqueda.

Implicaciones para el Sector SEO

Creación de una Marca Fuerte

Las filtraciones de información subrayan la importancia de crear una marca fuerte. Las señales de experiencia, competencia, autoridad y confiabilidad (E-E-A-T) son fundamentales, pero los datos sobre la intención del usuario, recogidos a través de los patrones de clics, parecen jugar un papel igualmente significativo. Esto implica que los profesionales del marketing deben concentrarse no solo en la calidad del contenido, sino también en la interacción de los usuarios con sus sitios.

Mayor Criticidad hacia las Declaraciones de Google

El autor del artículo insta a una mayor atención por parte del sector SEO al reportar las declaraciones de Google. Las discrepancias entre las declaraciones públicas y las prácticas sugeridas por las filtraciones de información resaltan la necesidad de un enfoque más crítico. Es importante que los profesionales del marketing sean conscientes de las verdaderas modalidades operativas de Google y no se confíen exclusivamente en las declaraciones oficiales.

Importancia de la Transparencia

La transparencia en el modo en que opera Google es crucial, dada su influencia en la difusión de la información. Las filtraciones de información ofrecen una oportunidad para reflexionar sobre la importancia de una mayor transparencia y claridad en las prácticas de Google. Esto no solo ayudaría a los profesionales del marketing a comprender mejor las dinámicas del ranking, sino que también aumentaría la confianza de los usuarios en los resultados de búsqueda.

Veamos los puntos importantes

| Punto destacado | Descripción |

|---|---|

| Fuga de información de la API de Google Search | Un informante anónimo compartió con Rand Fishkin, autor del artículo y fundador de SparkToro, más de 2.500 páginas de documentación de la API que parecen provenir del «Content API Warehouse» interno de Google. La fuente afirma que estos documentos filtrados han sido confirmados como auténticos por ex empleados de Google. |

| Afirmaciones extraordinarias | La fuente anónima hace varias afirmaciones extraordinarias, incluyendo que Google ha reconocido la necesidad de datos clickstream completos para mejorar la calidad de los resultados de su motor de búsqueda, que un sistema llamado «NavBoost» utiliza los datos clickstream para mejorar la relevancia de la búsqueda y que Google utiliza el historial de cookies, los datos de Chrome de los usuarios registrados y la detección de patrones para combatir el spam de clics. |

| Autenticación de la fuga de información | Para verificar la autenticidad de la fuga de información, Fishkin contactó a ex empleados de Google y al experto en SEO Mike King, quienes confirmaron que los documentos parecen auténticos y contienen información previamente no confirmada sobre el funcionamiento interno de Google. |

| El Content API Warehouse de Google | Se cree que la fuga de información proviene de GitHub, donde se hizo pública por error durante un breve período entre marzo y mayo de 2024. Se dice que la documentación de la API explica varios atributos y módulos de la API para ayudar a familiarizar a quienes trabajan en un proyecto con los elementos de datos disponibles. |

| NavBoost y el uso de datos de clics | Varios módulos en la documentación se refieren a características como «goodClicks», «badClicks», «lastLongestClicks», impresiones y clics comprimidos, no comprimidos y unicorn, todos relacionados con NavBoost, un sistema que Google utiliza para mejorar la relevancia de la búsqueda. |

| Uso de los clickstreams del navegador Chrome | Los documentos de la API sugieren que Google calcula varios tipos de métricas que pueden ser consultadas utilizando las vistas de Chrome relacionadas tanto con páginas individuales como con dominios completos. |

| Listas blancas en viajes, Covid y política | Un módulo sobre «sitios de viajes de buena calidad» sugiere la existencia de una lista blanca en Google en el sector de viajes. Referencias a flags como «isCovidLocalAuthority» e «isElectionAuthority» sugieren que Google coloca en la lista blanca ciertos dominios apropiados para mostrar en consultas potencialmente problemáticas. |

| Uso de los comentarios de los Quality Rater | Los documentos proporcionan pruebas de que Google utiliza elementos de su programa de evaluación de calidad, EWOK, en sus sistemas de búsqueda. Aunque no está claro cuán influyentes son estas señales basadas en evaluadores, esto indica que las evaluaciones humanas de los sitios web son importantes para Google. |

| Google utiliza datos de clics para determinar cómo ponderar los enlaces en los rankings | La fuente anónima afirma que Google utiliza los datos de clics para determinar en cuál de sus tres niveles de índice de enlaces (baja, media y alta calidad) pertenece un documento. Los enlaces provenientes del índice de enlaces de baja calidad no dañarán la clasificación de un sitio; simplemente se ignoran. |

| Consideraciones generales para los expertos en marketing | El artículo concluye que la marca es el factor de clasificación más importante en Google, que los factores de clasificación clásicos como PageRank y el texto de anclaje están disminuyendo en importancia, que los títulos de las páginas siguen siendo bastante importantes y que el SEO probablemente es menos eficaz para las pequeñas y medianas empresas en comparación con el pasado. |

Conclusión

Las recientes filtraciones de la API de búsqueda de Google han ofrecido una visión única y detallada sobre las actividades internas del motor de búsqueda más utilizado del mundo. Desde los comportamientos de los clics hasta la ponderación de los enlaces, pasando por el uso de los clickstream del navegador Chrome y las listas blancas, estas revelaciones tienen implicaciones significativas para el sector SEO. Es evidente que Google recoge y utiliza una amplia gama de datos para mejorar la relevancia y la calidad de los resultados de búsqueda. Para los profesionales del marketing, esto significa que es esencial comprender no solo los principios teóricos del SEO, sino también las prácticas reales que Google utiliza para determinar los rankings.

En un mundo donde la visibilidad online es crucial, conocer los secretos del funcionamiento de Google puede marcar la diferencia entre el éxito y el fracaso. Las revelaciones de Rand Fishkin y la confirmación de la autenticidad de los documentos por parte de expertos del sector subrayan la importancia de mantenerse actualizado y adaptarse constantemente a la nueva información. La transparencia y la claridad en las prácticas de Google no solo ayudarían a los profesionales del marketing, sino que también aumentarían la confianza de los usuarios en los resultados de búsqueda.

Preguntas Frecuentes

1. ¿Qué se debe hacer a partir de ahora con el SEO?

A la luz de las recientes revelaciones, es importante que los profesionales del SEO se centren más en la creación de contenido de alta calidad y en la interacción de los usuarios con sus sitios. Parece que Google está dando cada vez más peso a las señales de comportamiento de los usuarios, como los clics y las visualizaciones, por lo que asegurarse de que el sitio ofrezca una experiencia de usuario positiva se vuelve crucial. Además, construir una marca fuerte y confiable es esencial, ya que las señales de autoridad y confianza pueden influir significativamente en el posicionamiento en los resultados de búsqueda.

2. ¿Tienes algún consejo basado en lo que acaba de suceder con la filtración del algoritmo?

Sí, es fundamental adoptar un enfoque más crítico hacia las declaraciones oficiales de Google. Las discrepancias entre las prácticas internas reveladas y las comunicaciones públicas de Google sugieren que los profesionales del SEO deben basar sus estrategias no solo en las directrices oficiales, sino también en análisis profundos y datos empíricos. Invertir en herramientas de monitoreo del comportamiento de los usuarios y probar continuamente nuevas técnicas puede ayudar a mantenerse al día con las evoluciones del algoritmo de Google y a mantener una posición competitiva en los resultados de búsqueda.

3. ¿Podemos seguir haciendo el SEO de siempre a partir de ahora?

No, no podemos seguir haciendo el SEO de siempre sin adaptarnos a la nueva información revelada. Aunque los principios fundamentales del SEO, como la creación de contenido de calidad y la optimización técnica del sitio, siguen siendo válidos, es evidente que Google está evolucionando su algoritmo para dar mayor importancia a las señales de interacción de los usuarios y a los datos de clickstream. Por lo tanto, es necesario actualizar las estrategias de SEO para incluir estas nuevas consideraciones, centrándose en cómo los usuarios interactúan con el sitio y cómo estos comportamientos pueden influir en el posicionamiento.

Google Trends: Estrategias de Marketing

Google Trends: Estrategias de Marketing y Ventas para tu Negocio Google Trends es una herramienta poderosa que te permite aprovechar los…

Google Analytics 4 informe en tiempo real: todo lo que

Google Analytics 4 informe en tiempo real: todo lo que necesitas saber Google Analytics 4 (GA4) ha cambiado la forma en…

GeanAI y el creator marketing: el futuro de la publicidad

GeanAI y el creator marketing: el futuro de la publicidad en vídeo En la Advertising Week 2024, Meta presentó grandes actualizaciones…

Cómo Establecer el Presupuesto Adecuado para tus Campañas Publicitarias Online

¿Cuánto cuesta hacer campañas online? Guía completa sobre cómo establecer el presupuesto Si te preguntas cuánto cuesta hacer campañas online, no…

Cuatro consejos para optimizar las imágenes en tu sitio web

4 consejos para optimizar las imágenes en tu sitio web Las imágenes son un elemento crucial para cualquier sitio web….

Nuevas Posibilidades para los Shorts de YouTube

Nuevas Posibilidades para los Shorts de YouTube YouTube sigue evolucionando y adaptándose a las tendencias del consumo de contenido, y los…

Las respuestas de Google a las preguntas de la comunidad:

Veamos cómo Google ha respondido a las mejores preguntas realizadas por la comunidad de entusiastas en la publicación de junio…

Mitos y Realidades del SEO: Separar los Hechos de la

En este artículo exploraremos los mitos más comunes sobre el SEO y las realidades correspondientes, proporcionando una guía clara y…

5 aplicaciones de IA en oferta del mes de junio

Estoy feliz de presentarles 5 magníficas herramientas de AppSumo que vale la pena probar. Cada mes selecciono para ustedes una…

Descubramos el nuevo modelo de OpenAI GPT-4o

Descubre las novedades del nuevo modelo AI de OpenAI: GPT-4o OpenAI ha lanzado recientemente su nuevo modelo de inteligencia artificial, GPT-4o,…